Teste - administrarea unei scântei de

Spark - o infrastructură de calcul cu open source, proiectat pentru a lucra cu așa-numitele mari de date (Big Data); este din ce în ce mai popular, în special în scenarii de învățare automată. In acest articol voi descrie cum se instalează Spark la un computer care rulează un sistem de operare Windows, și va explica funcționalitatea de bază în ceea ce privește NET-dezvoltator.

Fig. 1. Spark în acțiune

scânteie-shell Scala genereaza interpretor de comenzi, care se realizează în coajă și la rândul lor generează un prompt pentru a introduce Scala (timpanică>). Scala - este un limbaj de scripting bazat pe Java. Există și alte modalități de a interacționa cu Spark, dar utilizarea Scala interpret - abordarea cea mai comună în parte, deoarece infrastructura Spark este scris pentru cea mai mare parte pe Scala. De asemenea, puteți interacționa cu Spark, folosind comenzile Python sau crearea unui program în Java.

Să acorde o atenție la unele avertismente în Fig. 1. Aceste mesaje apar foarte des la pornire Spark, deoarece Spark are o multitudine de componente opționale, care sunt generate în absența unui avertisment. În principiu, aceste mesaje pot fi ignorate în scenarii simple.

Prima echipă a intrat în sesiune demo:

Interpretarea liberă înseamnă „a salva conținutul README.md unui fișier într-un obiect imuabil RDD-f». Scala obiecte pot fi declarate ca un val sau var. Obiectele declarate ca un val, sunt imuabile.

În Scala interpret încorporat context Spark obiect numit sc, care este folosit pentru a accesa funcționalitatea Spark. Funcția Textfile încarcă conținutul unui fișier text în structura de date Spark numit un set de date distribuite tolerante la defecte (CCD elastic distribuite, RDD). RDD sunt abstractizare software-ul de bază utilizate în Spark. Vă puteți gândi la RDD ceva similar cu NET-set stocate în memorie și distribuite pe mai multe mașini.

Fișier text README.md (extensia .md indică «documentul markdown» [Document Markup]) este localizat în directorul rădăcină C: \ spark_1_4_1. Dacă fișierul țintă se află în altă parte, puteți specifica calea completă, de exemplu, C: \\ Date \\ ReadMeToo.txt.

A doua comandă în cadrul sesiunii demo:

Acest lucru înseamnă: „Salvați ca imuabile RDD-obiect numit ff numai acele rânduri din obiectul f, care este cuvântul«Spark»». Filtrul de funcții ia așa-numita de închidere (de închidere). Circuitul poate fi privit ca ceva de genul o funcție anonimă. Există circuitare ia un parametru de intrare linie șir și returnează true, în cazul în care linia conține «Spark», sau false în caz contrar.

Deoarece linia - un nume de parametru, am putea folosi în închiderea oricărui alt nume, de exemplu:

conta funcția returnează numărul de elemente din DZR - în acest caz, numărul de rânduri din fișierul README.md care conțin cuvântul «Spark». Aceste rânduri - 19. Pentru a ieși din sesiunea Spark Scala, introduceți comanda: q.

Instalarea Spark pe mașina Windows

Spark procesul de instalare de pe computerul Windows este format din patru etape principale. În primul rând, instalați kitul de dezvoltare Java (JDK) și Java Runtime Environment (JRE). În al doilea rând, setați limba Scala. În al treilea rând, instalați infrastructura Spark. Și al patrulea rând, variabilele de sistem sunt configurate pe mașina gazdă.

distribuție Spark este prevăzut în format .tar comprimat, astfel încât veți avea nevoie de un utilitar pentru a extrage fișierele Spark. Te sfătuiesc să instalați programul 7-Zip cu open source.

JDK se execută un fișier executabil cu auto-extragere pe care le găsiți căutarea pe Internet. Am folosit o versiune a JDK-8u60-ferestre-x64.exe.

Când instalați versiunea pe 64 de biți JDK directorul de instalare implicit este C: Files \ Program \ Java \ jdkx.x.x_xx \, așa cum este prezentat în Fig. 2. Se recomandă să nu se schimbe directorul implicit.

Fig. 2. Directorul de instalare implicit JDK

La instalarea JDK este instalat și JRE asociat. Instalarea Java este completă, directorul părinte va fi implicit directorul JDK și directorul JRE asociate, așa cum este prezentat în Fig. 3.

Fig. 3. Java JDK și JRE, instalat în C: \ Program Files \ Java \

Rețineți că aveți în sistem probabil va apărea, de asemenea, director Java, cu unul sau mai multe cataloage de 32 de biți JRE din C: \ Program Files (x86). Acest lucru este normal, atunci când sistemul are versiuni pe 32 de biți și 64 de biți de JRE, dar te sfătuiesc să utilizați numai versiunea pe 64 de biți a Java JDK.

instalarea Scala

Următoarea etapă - instalarea limbii Scala, dar mai întâi trebuie să mergi la un site web pentru a descărca Spark (descris în următoarea secțiune a acestui articol), precum și pentru a determina ce versiune doriți să instalați Scala. Versiunea Scala trebuie să fie compatibile cu versiunea Spark, care va fi instalarea în etapa următoare.

Din păcate, informații despre Scala și compatibilitate versiunea Spark este foarte slabă. Când am instalat componentele Spark (ceva timp în urmă), versiunea actuală a fost 1.5.0 Spark, dar am putut găsi nici o informație despre ceea ce versiunea Scala este compatibilă cu această versiune a modelului Spark. De aceea, eu prefer versiunea anterioară a modelului Spark (1.4.1), găsit unele informații pe forumurile pentru dezvoltatori, în cazul în care a fost raportat că versiunea Scala 2.10.4 probabil compatibil cu Spark 1.4.1.

Set Scala cu ușurință. Pentru a face acest lucru, pur și simplu executați fișierul de instalare .msi.

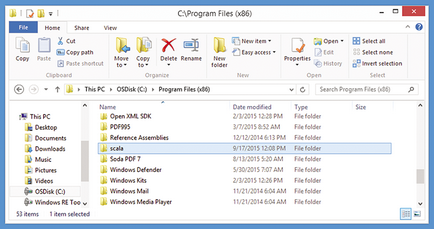

Scala proces se execută expertul de configurare. Curios, directorul de instalare implicit pentru Scala este localizat în directorul pentru programe pe 32 de biți - C: \ Program Files (x86) \, și nu mai degrabă în directorul pentru 64-bit - C: \ Program Files \ (figura 4).

Fig. 4. Scala este setat la C: \ Program Files (x86) \ timpanică \

Dacă intenționați să coopereze cu Spark, crearea unui program de Java, mai degrabă decât folosind echipa Scala, ai nevoie de mai mult de utilitate - Scala Tool Build simplă (SBT). Interacțiunea cu Spark compilate prin intermediul Java program este mult mai dificil decât interactiv Scala miercuri.

instalarea Spark

Următorul pas - intrastuctură Spark. Dar, mai întâi asigurați-vă că aveți un program de sprijin cum ar fi 7-Zip, capabil de a despacheta format de fișier .tar. Spark Procesul de instalare se face manual, permițându-vă să descărcați un folder comprimat pe o mașină locală, extragerea fișierelor comprimate și copiați-le în directorul rădăcină. Deci, dacă doriți să eliminați Spark, Spark apoi ștergeți doar fișierele.

Site-ul Spark - spark.apache.org. pagina de descărcare vă permite să selectați tipul și versiunea pachetului. Spark - o infrastructură de calcul, care necesită prezența unui sistem de fișiere distribuit (sistemul de fișiere distribuit, DFS). Până în prezent, cele mai frecvente DFS, utilizat cu infrastructura Spark - Distributed System File Hadoop (HDFS). Pentru testarea și experimentarea, cum ar fi sesiunea de demonstrație în Fig. 1. Spark poate fi instalat în sistem fără a fi nevoie DFS. În acest scenariu, Spark va utiliza sistemul de fișiere local.

Dacă nu ați despachetat fișiere .tar, acest proces poate părea un pic confuz, pentru că, de regulă, trebuie să extrage fișierele de două ori. În primul rând, descărca fișierul .tar (am un fișier numit scânteie-1.4.1-bin-hadoop2.6.tar) în orice director temporar (am folosit C: \ Temp). Apoi, faceți clic dreapta pe fișierul .tar, selectați fișierele Extras din meniul contextual, și extrage conținutul într-o locație nouă în timp.

La prima trecere, un nou despachetați fișierul comprimat, fără nici o extensie (în cazul meu - scânteie-1.4.1-bin-hadoop2.6). Apoi, faceți clic dreapta pe noul fișier, din nou, selectați fișierele Extras din meniul contextual, și extrage conținutul într-un alt director. După a doua trecere sunt fișiere de infrastructură Spark.

Creați un director pentru aceste fișiere. Potrivit acordului de distribuție, trebuie să creați un director C: \ spark_x_x_x, unde x - valori care specifica versiunea. Folosind această convenție, am creat un director C: \ spark_1_4_1 și copiați fișierele extrase (Figura 5.).

Configurarea calculatorului

După instalarea Java, Scala și Spark rămâne pentru a configura mașina gazdă. Acest proces implică descărcarea de fișiere auxiliare speciale pentru Windows, stabilind trei variabile de mediu de sistem, definite de utilizator variabile sarcină de mediu Path, și (opțional), o modificare a modelului Spark fișier de configurare.

Spark rulează pe Windows necesită ca acest fișier auxiliar de construcții, winutils.exe, situat în directorul local C: \ Hadoop. Puteți găsi acest fișier în mai multe locuri de pe căutare pe Internet. Am creat un folder C: \ Hadoop, și apoi a găsit o copie a winutils.exe link-ul public-repo-1.hortonworks.com/hdp-win-alpha/winutils.exe și descărca fișierul în directorul său.

Apoi, creați și configurați variabilele de sistem, definite de utilizator, și să modifice mediul Path variabila. Du-te la Panoul de control | Sistem | Setări avansate de sistem | avansat | Variabile de Mediu. În secțiunea Variabile de utilizator, de a crea trei noi variabile, cu următoarele nume și valori:

Funcția reduceByKey combină elemente ale obiectului m, adăugând valorile întregi care sunt asociate cu aceleași chei. Cts.take de comandă (10), veți vedea 10 cuvinte de README.md, urmată de numărul de ori fiecare cuvânt apare în fișierul. În plus, veți observa, probabil, că cuvintele din obiectul nu cts neapărat urmată în nici o ordine anume.

Funcția ia circuitului reduceByKey. Prin urmare, puteți utiliza o alternativă Scala notație prescurtare:

Astfel, avem 66 de cuvinte goale / null în README.md, 21 cuvântul «», 14 cuvinte «Spark» și așa mai departe. D.

concluzie

Îmi exprim recunoștința pentru experții Microsoft articol care analizează Gaza Iqbal (Gas Iqbal) și Umesh Madani (Umesh Madan).